자동 자막의 시대가 열렸습니다. Whisper AI는 인공지능 기술을 이용하여 음성 언어를 자동으로 텍스트로 변환해주는 소프트웨어입니다. 이를 통해 개인과 기업은 음성 콘텐츠를 수동으로 전사하지 않아도 되어 시간과 생산성을 절약할 수 있습니다. 즉, 야X 동영상과 혹은 외국의 영상 등에서 자동으로 자막을 만들어서 한글로 볼 수 있는 시대가 도래했습니다.

해당 버전보다 조금 더 정확한 로컬 WebUI 버전 설치하는 방법 가이드

2023/08/29

Whisper-webui huggingface 버전 Local 설치하기

(설치 과정이 약간 더 복잡하나 성능이 조금 더 낫고, 오류가 없습니다.)

크롬에 자동 번역 기능이 추가된 지도 얼마 되지 않은 것 같은데, 이제는 음성까지도 한글로 바꿀 수 있습니다. 확실히 영어가 인식률이 높긴 하지만 영어 뿐 아니라 한글, 일본어도 됩니다.

활용할 방법은 무궁무진합니다. Asmr 영상이나 혹은 일본 동인 음성과 같은 것들도 번역할 수 있고, 일본 AV 영상 들도 일본어를 전혀 몰라도 자막을 만들 수 있습니다. 물론, 완벽하게 싱크를 맞춰주진 않지만 수작업으로 싱크를 수정하여 더 완벽하게 만들 수 있습니다.

PC에 설치하지 않고 whisper Ai 사용하는 방법

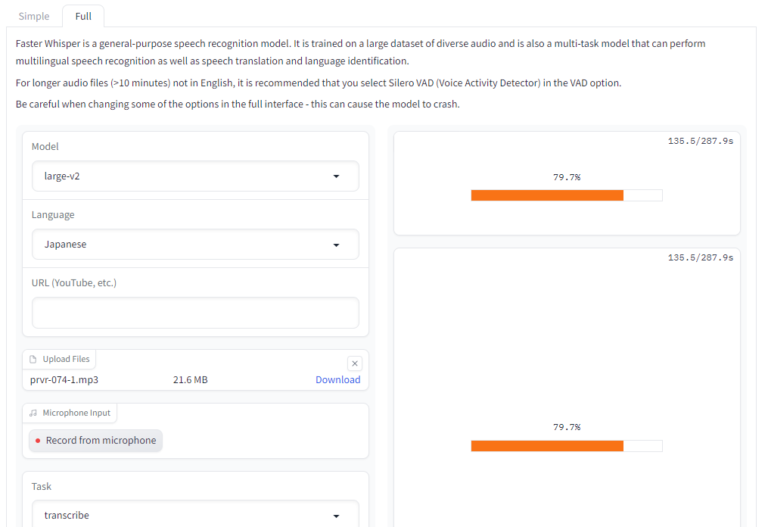

https://huggingface.co/spaces/aadnk/faster-whisper-webui

해당 사이트에 들어가서 mp3 파일이나 유튜브 주소를 붙여넣으면 알아서 해줍니다. 하지만 온라인으로 하면 조금 느립니다. 저걸 다운로드 받아서 로컬에서 돌릴 수도 있습니다.

위스퍼(whisper) Ai를 활용하는 방법은 꽤 많습니다. 구글 코랩에서 돌리거나 혹은 구글 드라이브에서 돌리는 방법도 있지만, 네카오소프트에서는 Webui를 활용한 방법을 사용하도록 하겠습니다.

2023/04/02추가 번역 개꿀 팁 추가!

해당 번역으로 이용 시 품질 이슈가 있어서 그냥 구글 번역, 파파고, Deepl 추천드립니다.

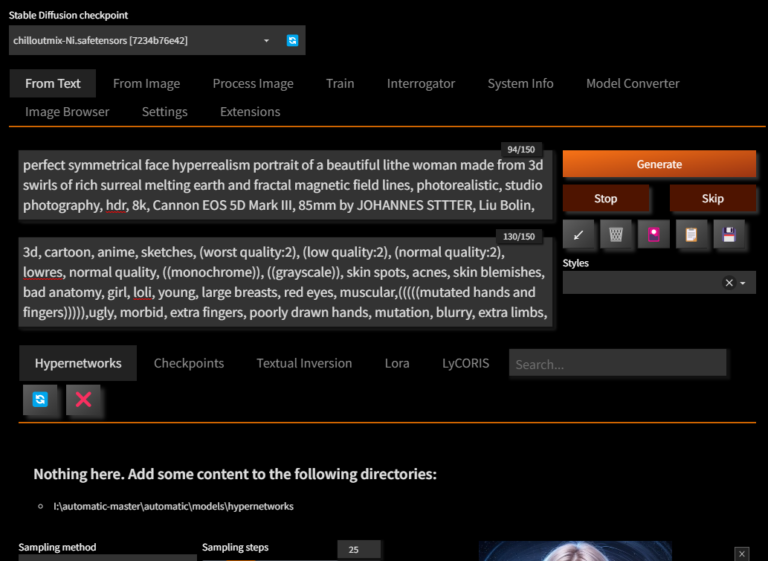

Webui 인터페이스 이미지

이런식으로 실행되는 모습을 많이 보셨을 겁니다. Ai 그림을 뽑으시는 분들이 가장 많이 보는 Ui일 것입니다. 이런식으로 쉽게 적응한 화면으로 ai 프로그램을 실행할 수 있습니다. 설치하는 방법을 알아보도록 하겠습니다.

먼저 다운로드 받아야 할 것은, git과 파이썬 그리고 FFmpeg입니다.

필수 설치 파일 다운로드

먼저 깃을 설치해 주신 다음에 파이썬을 설치합니다. 파이썬은 3.11 버전이 아니라 3.10 버전을 설치해야 합니다. 그리고 FFmpeg 파일을 설치해줍니다. 각 문서마다 어떻게 설치하는지 방법이 나와 있으니 정독하시고 설치하시면 됩니다. 설치가 완료됐다면, Whisper-WebUI를 설치해봅시다.

FFmpeg 설치 후 꼭 해야하는 것!

FFmpeg를 설치한 후, 경로 : C:\Program Files\ffmpeg\bin

이것을 시스템 Path 폴더에 추가를 해줘야 합니다. 어떻게 하느냐?

[고급] -> [환경변수] 버튼을 눌러줍니다.

윈도우 검색창에서 고급 시스템 <- 아래와 같이 검색하면 바로 뜨게 됩니다. 제어판에서 찾아서 들어가셔도 됩니다.

변수에 path라고 되어 있는 것을 찾습니다. 클릭 후 [편집]을 눌러줍니다.

환경 변수에서 새로 만들기를 누르시고, C:\Program Files\ffmpeg\bin 주소를 등록합니다. ffmpeg의 bin 폴더를 등록하시면 됩니다. 만약 다른 폴더에 설치되셨다면 그냥 프로그램 파일에 ffmpeg 폴더를 붙여넣으시면 저렇게 됩니다. 그런 다음 ffmpeg\bin 주소를 패스에 등록해주세요. 그럼 준비는 완료됐습니다.

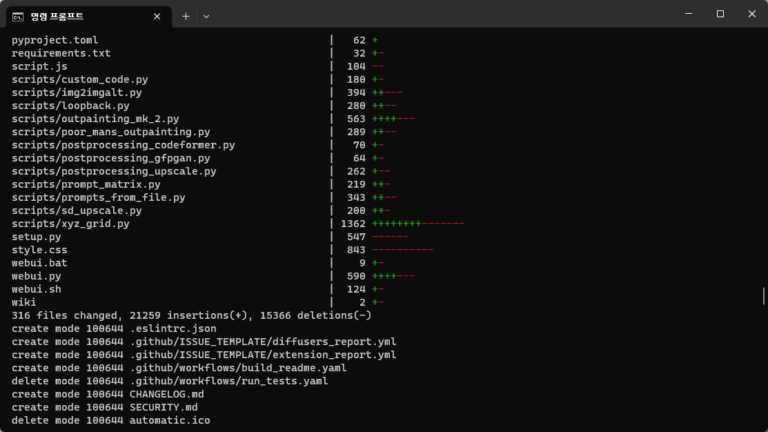

Whisper-WebUI 다운로드

Whisper-WebUI를 다운받아주세요. 다운로드를 받으면 이런 식으로 폴더가 나타나 있을 겁니다.

install.bat 파일을 실행시켜줍니다. 꽤 시간이 걸리는 편입니다. webui 그림 생성과 마찬가지로 특정 모델을 다운로드 받아야 합니다. 그렇기에 다운로드 속도가 꽤 걸리는 편입니다. 다운로드가 완료됐다면, start-webui.bat 파일을 실행시켜줍니다. 정상적으로 실행됐다면 아래와 같은 화면이 송출될 겁니다.

그런 다음 아래의 주소로 들어갑니다.

위의 주소가 접속이 되지 않는다면, 아래의 주소가 있습니다.

위스퍼AI Webui 사용법

자막을 만들 영상, mp3 등의 파일을 집어넣습니다. 용량이 크다면 업로드 하는 데 시간이 꽤 걸리니까 조금 기다려야 합니다.

이렇게 [업로드]에서 [다운로드]로 바뀌면 이제 위스퍼 Ai를 사용할 준비가 모두 끝났습니다. 아래의 옵션을 살펴보도록 하겠습니다.

참고사항

기존에 MP4파일을 그대로 올렸더니 C 드라이브 용량이 남아나질 않았습니다. temp 파일에 들어가서 일일이 삭제하는 것도 고역이었습니다.

이런 부분을 방지하려면 샤나인코더를 활용해서 mp4->mp3로 용량을 확 낮춰서 사용하십시오. 이렇게 하니 업로드 속도도 매우 빨라지고, 용량 차지도 줄어들었습니다.

임시파일 저장되는 경로

C:\Users\[유저이름]\AppData\Local\Temp -> 여기에 저장됩니다. 이름이 바뀌기에 크기명으로 정렬하셔야 합니다.

- 모델 : 위스퍼 Ai 모델을 선택합니다. 현재 large-v2가 가장 최신 버전입니다.

- language : 자동으로 언어 선택을 할 수도 있지만, 그래도 영상, 음원 파일의 언어를 선택합니다.

- subtitle Format : 뽑아낼 형식을 선택합니다. 저는 SRT 자막 파일로 뽑겠습니다.

모델 설명

매개 변수 모델은 모델의 매개변수 크기 범위는 초소형의 경우 39M, 대형의 경우 최대 1550M까지 커질 수 있습니다. 당연히 초소형의 모델의 경우 음성 인식률이 줄어듭니다. tiny -> large로 올라갈 수록 점점 모델이 무거워진다고 할 수 있습니다.

그럼 그냥 large를 쓰면 되냐?

예, 쓰면 좋습니다만 그래픽카드 Vram이 어느 정도나 되냐가 가장 중요합니다.

Whisper 모델병 Vram 요구치

| 크기 | 매개변수 | 다국어 모델 | 필수 VRAM | 상대 속도 |

|---|---|---|---|---|

| tiny | 39M | tiny | ~1GB | ~32배 |

| base | 74M | base | ~1GB | ~16배 |

| samll | 244M | small | ~2GB | ~6배 |

| medium | 769M | medium | ~5GB | ~2배 |

| large | 1550M | large | ~10GB | 1x |

즉 라지를 이용하려면 Vram 필요치가 10GB입니다. 무조건 3000번대 이상의 그래픽 카드가 강요되고 있습니다. 요즘 그래픽 카드 기업들이 왜 웃고 있는지 알 수 있는 부분입니다. 네카오소프트는 3080ti를 사용중이기 때문에 large를 하여 kbs 뉴스를 한 번 사용해보겠습니다.

깨알 팁 : 모델 뒤에 en이 붙은 것은 영어 모델 전용입니다. 만약 영문 인식을 하시려면 en이 붙은 것으로 해주시면 됩니다. 하지만 large가 더 좋습니다.

결과 공유

(영상을 보며 비교해보세요. 얼마나 정확한 지)

자막뉴스 두 눈 시퍼렇게 뜨고 있는데tuqd4xsm..’와~ 이걸’ 제멋대로 불법 KBS 2

1

00:00:00,000 –> 00:00:03,000

인천 부평역의 지하도 상가.

2

00:00:03,260 –> 00:00:06,000

10제곱미터 크기의 점포 1개 임대료는

3

00:00:06,240 –> 00:00:11,740

월 평균 20만 원 안팎입니다. 하지만 20만 원에 구할 수 있는 상가는

4

00:00:12,540 –> 00:00:15,280

없습니다. 매달 100만 원에서 200만 원은 줘야

5

00:00:15,580 –> 00:00:20,080

상가를 빌려 장사를 할 수 있습니다. 지방정부 소유의 상가를 상인들끼리

6

00:00:20,379 –> 00:00:25,879

거래해 왔기 때문입니다. 재임대가 가능한 임차권이 평균 3, 4억

7

00:00:25,879 –> 00:00:29,619

원, 최대 6억 원에 거래되기도 했습니다.

8

00:00:36,420 –> 00:00:41,920

–지하도 상가의 임차권을 매매나 재임대하는 것은 금지돼 있는데 인천시는

9

00:00:42,259 –> 00:00:44,960

2002년 조례로 이를 허용해 지금까지 거래가 이어져 왔습니다.

10

00:00:46,899 –> 00:00:51,500

감사원은 인천 지하도 상가 임차인의 절반이 이렇게 연간 수백억 원의 부당

11

00:00:51,500 –> 00:00:57,000

이득을 얻어왔다고 지적했습니다. 이 같은 불법을 허용했던 인천시의

12

00:00:57,299 –> 00:00:58,740

조례가 21년 만에 개정됐습니다.

13

00:01:05,040 –> 00:01:10,539

이 개정 조례에 따라 임차인들은 오는 9월 말까지 불법 재임대를 정리해야

14

00:01:10,540 –> 00:01:21,060

합니다.

15

00:01:24,560 –> 00:01:27,260

임차인들의 권리는 현재의 임대 계약이

16

00:01:27,560 –> 00:01:31,060

끝나는 최장 2037년까지 인정해 주기로 했습니다.

17

00:01:31,360 –> 00:01:34,540

그러나 임차인들은 인천시의 과거 조례에

18

00:01:34,800 –> 00:01:37,100

따라 수억 원을 투자했다며 반발하고

19

00:01:37,099 –> 00:01:42,599

있습니다.

20

00:01:47,179 –> 00:01:52,679

임차인들은 2002년 조례를 만든 공무원들을 고발하고 손해배상 소송을 제기할

21

00:01:53,319 –> 00:01:54,819

방침입니다. KBS 뉴스 박재우입니다.

22

00:01:54,819 –> 00:02:04,819

-!(앵커 끝 소리).

확인해보셨다면 알 수 있을 겁니다. 얼마나 정확한 음성 인식률을 가지고 있는지 말입니다.

이런 식으로 자막을 쉽게 만들 수 있으니 정말 활용할 곳이 많을 것 같습니다.

그리고 저장된 Srt 파일을 찾고 싶으면

하단 우측에 있는 폴더 모양을 누르시면 파일이 만들어지는 폴더로 자동으로 이동됩니다. srt 파일을 설정해서 잘 활용해주시기 바랍니다.

위스퍼 Ai로 뽑아낸 SRT 파일 활용팁

여기에서 가장 중요한 점은 SRT 파일을 어떻게 수정하느냐죠?

만약 일본어나 영어로 자막을 뽑아냈다고 해도 한글로 바꾸지 못하면 아무런 소용이 없지 않을까요?

먼저 srt 파일 내에 있는 텍스트를 뽑아내야 합니다.

이게 귀찮으시면 http://127.0.0.1:7861/에서 만들어진 Output 결과물을 전체 복사하면 됩니다.

오른쪽 마우스 클릭 -> 속성 -> 연결프로그램 변경 -> 메모장으로 변경

메모장으로 변경해도 Srt 확장자가 안 먹히는 건 아닙니다. 다만 자막 파일을 실행하면 이제 메모장으로 열리는 게 달라지는 겁니다. 어떤 화면으로 되어 있는지 확인합니다.

srt를 메모장으로 열어보면 이렇게 되어 있습니다. 00:00:00, –> 00:00:03은 자막이 나오는 시간을 나타내는 겁니다. 그리고 아래의 텍스트는 [자막]이고요. 조금 어색한 부분이 있다면 자막을 수정하면 되고, 시간을 수정하려면 시간을 살짝 수정하면 됩니다.

영어, 일본어 및 타국어 번역하는법

가장 쉬운 방법

가장 쉬운 방법은 그냥 txt 파일로 열어서 크롬 번역기를 이용하는 겁니다.

크롬이 없으시다면 여기서 다운로드 받을 수 있습니다.

자막을 변역하는 방법 중에 가장 간단한 방법입니다. srt 파일의 확장자 명을 txt로 바꿔주신 후에, 텍스트 파일 자체를 크롬이 열려있는 화면에 넣어주시면 텍스트 파일을 크롬이 읽게 됩니다. 마우스 오른쪽 버튼을 누르면 크롬 자체에서 제공하는 번역을 사용할 수 있습니다.

일본어, 영어, 중국어 등의 자막을 txt 형태로 번역하고, 전체 복사하여 다시 txt 파일에 붙여넣은 후 저장하는 겁니다. 그런 다음 srt 파일로 다시 바꾸면 됩니다.

다만, 번역기 성능이 중간급에 해당됩니다.

가장 쉬운 방법2

네이머 메일에 들어갑니다.

그런 후, 자기 자신에게 메일 쓰기를 합니다.

만들어진 자막 파일 내용으로 메일을 보냅니다.

내게 온 메일 확인을 하시고, 들어가시면 번역하기 버튼이 존재합니다.

이것도 가장 빠르게 사용할 수 있습니다. 영어는 모르겠지만, 일본어 같은 경우에는 크롬보다 나은 성능을 자랑하고 있더군요.

적당히 귀찮은 방법

deepl을 이용하는 겁니다.

Deepl 번역기를 이용하게 된다면, 고품질의 번역을 사용할 수 있습니다.

다만, 문제점은 deepl 번역기를 사용하면 시간대가 오류가 생기기도 합니다.(오류가 생기는 부분은 홀로 수정해야 합니다.)

또한, 번역 제한이 5,000자라서 긴 자막의 경우에는 여러 번 잘라서 번역해야 합니다.

추가 번역 팁

사용해보다가 T2T translation을 보았습니다. 이게 뭔가 하니 번역을 해주는 툴이었다는 걸 알았습니다. mp3로 만든 srt 파일을 넣어주고, 버튼을 눌러주게 된다면 번역까지 완벽하게 됩니다.

- source Languege : 원문 언어 선택

- Target Languege : 번역될 언어 선택

쉽게 번역까지 완료 할 수 있습니다. 파파고 메일 번역이나 기타 deepl 번역기를 쓰는 것보다 훨씬 간단하게 사용할 수 있습니다.

궁금한 게 있으시면 질문해주시길 바랍니다.

위스퍼 오류 질문

mov,mp4,m4a,3gp,3g2,mj2 관련 오류

[mov,mp4,m4a,3gp,3g2,mj2 @ 000001c044d0da00] Format mov,mp4,m4a,3gp,3g2,mj2 detected only with low score of 1, misdetection possible!

[mov,mp4,m4a,3gp,3g2,mj2 @ 000001c044d0da00] moov atom not found

이런 오류가 뜬다면 해당 확장자 영상이 아니거나

대부분의 경우 아직 영상이 업로드가 안 되서 그렇습니다.

위스퍼는 특정 로컬 주소에 영상을 옮긴 후, 음성 인식 작업을 들어갑니다.

참고 : 영상 파일 저장되는 로컬 주소

C:\Users\[사용자명]\AppData\Local\Temp

Vram 문제 해결법

현재 jhj0517/Whisper-WebUI의 깃허브 웹UI의 문제가 있는 것으로 보입니다. 본래 base모델이나 미디움 모델로 설치할 경우에는 자동으로 Vram 할당량이 바뀌어야 합니다. 그러나 webui 위스퍼의 문제로 처음부터 실행시 자동으로 large 모델이 설치되고, 실행됩니다.

그렇기에 이 부분을 수정하려면 파이선 코드를 수정해야 합니다.

I:\Whisper-WebUI-master\modules로 이동해주세요.

whisper_Inference.py 파일을 실행합니다.

여기서 디폴트 모델 사이즈를 라지-v2에서 스몰이나 미디움 원하시는 것으로 바꿔야 합니다. 해당 파이선 코드 수정이 어려운 분들을 위해 제가 해당 부분만 수정한 파이썬 파일을 만들어서 업로드했습니다. 아래에서 다운로드 받아주세요.

스몰과 미디움에 관해서 어떤 것을 선택해야 할지 고민되신다면, #Whisper 모델병 Vram 요구치 를 참고해주시길 바랍니다.

또한, 허깅페이스 모델을 로컬로 돌리는 방법이 있습니다. 해당 방법은 아나콘다 및 cmd 파일로 설치하는 것이지만 PDF 파일로 따라하기만 설치가 완료되는 과정입니다. 원클릭 설치보다는 조금 난해합니다. 해당 방식으로 webui를 이용하시려면

위를 참고해주시길 바랍니다.

95개의 응답

안녕하세요

아주 아주 좋은 강좌라서 열심히 따라하기 했는데 …

start-webui 실행하면

return t.to(device, dtype if t.is_floating_point() or t.is_complex() else None, non_blocking)

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 26.00 MiB (GPU 0; 8.00 GiB total capacity; 7.00 GiB already allocated; 0 bytes free; 7.36 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

계속하려면 아무 키나 누르십시오 . . .

이런 문구가 계속 나오는데 설치가 잘안된것같아요

뭔가 빼먹은게 있는지 확인좀 ㅠㅠ

python-3.10.10-amd64 설치

Git-2.40.0-64-bit 설치

ffmpeg C:\Program Files\ffmpeg 설명대로 열심히 으샤으샤 했습니다

Whisper-WebUI-master Install 설치

start-webui 실행하면 위에 문구처럼 계속 뜨니까 ㅠㅠ

조금만 알려주세요 ㅠㅠ 파이팅 부탁드려요 감사합니다 고맙습니다

해당 오류는 26.00MiB의 메모리를 할당하는 동안 GPU의 메모리가 부족함을 나타내는 오류입니다. GPU에는 현재 7.00GiB의 메모리가 이미 할당되어 있으며 사용 가능한 여유 메모리가 없다고 하는 오류입니다. 라지 모델이 아니라 다른 모델을 선택해서 한번 돌려보시기 바랍니다.

똑같은 문제가 있는데 라지 모델이 아니라 다른 모델 선택은 어떻게 하나요?

안녕하세요

저도 댓글 작성자 분과 동일한 현상이 발생 중 인데요.

답변 주신 내용처럼 다른 모델을 선택하라고 하셨는데

small model로 선택을 어떻게 해야할까요?

다른모델을 선택하는 방법이 무엇인가요???

깃허브에서 medium.pt를 다운받아서 폴더에 넣었는데도 start-webui를 실행하면 large를 다운받습니다.

라지 모델이 아닌 다른 모델을 선택해서 돌려보라고 하셨는데

설치 시에 자동으로 라지 모델로 설치가 되는 것 같은데

어떻게 다른 모델로 선택을 해야하는지요?

http://nekaosoft.com/whisper/#vram-%EB%AC%B8%EC%A0%9C-%ED%95%B4%EA%B2%B0%EB%B2%95 해당 방법 참고바랍니다.

http://nekaosoft.com/whisper/#whisper-%EB%AA%A8%EB%8D%B8%EB%B3%91-vram-%EC%9A%94%EA%B5%AC%EC%B9%98 을 눌러서 모델별 VRam 필요치를 확인해보세요.

web이 실행되기 전에 wtart-webui.bat 상에서 해당 오류가 발생하여

web에서 모델을 교체할 수가 없습니다.

medium 모델을 따로 다운로드 하여 모델 폴더에 넣어봤찌만, large-v2가 없으면 large 모델을 다운받고, 다운로드 받아 large 모델과 medium 모델이 둘다 존재해도 large 모델을 기반으로 web 실행을 시도하여 같은 메모리 부족 오류를 출력합니다.

web 접속 전에 모델을 교체할 수 있는 방법이 있을까요?

start-webui 실행시 로컬라이징하면서 gpu가 올라가다가 확치솟으면서 저렇게 뜨는데 모델을 어떻게 바꿔서 실행을 시키나요?

자세한 안내 감사합니다. 다운로드 받은 whisper webui 파일을 설치 및 실행하면 large 모델로 자동 설치되던데 다른 모델로 선택하여 설치하는 방법은 없을까요?

http://nekaosoft.com/whisper/#vram-%EB%AC%B8%EC%A0%9C-%ED%95%B4%EA%B2%B0%EB%B2%95 해당 방법 참고하시면 기본 라지v2 모델에서 스몰이나 미디움으로 교환할 수 있습니다.

안녕하세요. 알려주신 방법 잘 사용하다가 cuda를 설치해서 gpu를 사용한 번역을 하고 싶어서 써보다가 다시 cpu만 사용하고 싶습니다. 그런데 cuda, conda, choch,등 gpu관련된 설정과 방법을 쓰다가 전부 삭제하고 cpu만 써보려고 해도 gpu설정을 그대로 써서 cpu번역이 되지않고 실행조차 안됩니다 ㅠㅠ 다시 돌릴 방법이 있을까요? 알려주신 방법 1번부터 전부 삭제하고 해봐도 안되네요 ㅠㅠ

Git, 파이썬 3.10.10, FFmpeg 등등과 webui 설치 파일들을 전부 삭제하고 다시 설치해보시길 바랍니다.

안녕하세요 글을 따라한 install.bat을 실행하면

Creating venv…

Pythonchecked the venv folder. now installing requirements..

지정된 경로를 찾을 수 없습니다.

‘activate.bat’은(는) 내부 또는 외부 명령, 실행할 수 있는 프로그램, 또는

배치 파일이 아닙니다.

‘pip’은(는) 내부 또는 외부 명령, 실행할 수 있는 프로그램, 또는

배치 파일이 아닙니다.

Requirements installation failed. please remove venv folder and run install.bat again.

계속하려면 아무 키나 누르십시오 . . .

라고 나옵니다만 무엇이 문제일까요?

파이썬 설치 시에 Add python 3.10 to PATH를 체크 했는지 확인해보세요. 다시 아니라면 파이썬을 삭제했다가 다시 설치해보시길 바랍니다. (체크한 후)

저도 이분하고 비슷하게 문제가 생기네요.

Add python 3.10 to PATH 를 체크하고 설치해도

Creating venv…

Pythonchecked the venv folder. now installing requirements..

지정된 경로를 찾을 수 없습니다.

‘activate.bat’은(는) 내부 또는 외부 명령, 실행할 수 있는 프로그램, 또는

배치 파일이 아닙니다.

라고 나오는데 어떻게 해야할까요?

가상환경이 제대대로 설치되지 않았을 때, 저러한 오류가 뜰 수 있습니다. 깨끗하게 위스퍼 파일을 삭제하고, 다시 Install.bat을 실행시켜보세요.

안녕하세요 좋은 글 잘봤습니다. 일단 다른 버그가 발생한거 같지만 다른 댓글에 있는 방식은 다 해보았음을 알려드립니다.

Running setup.py install for future … done 단어와 함께 설치완료후 start-web ui를 실행했을때

venv “C:\Users\pcroo\Desktop\Whisper-WebUI-master\\venv\Scripts\Python.exe”

Traceback (most recent call last):

File “C:\Users\pcroo\Desktop\Whisper-WebUI-master\app.py”, line 1, in

import gradio as gr

ModuleNotFoundError: No module named ‘gradio’

계속하려면 아무 키나 누르십시오 . . .

라고 커멘더에 뜨면서 실행되지 않습니다 모뎅리 감지가 안되는거 같은데 버그성인지 잘 모르겠어서 댓글 남깁니다! 코멘트 부탁드릴게여

안녕하세요. 파이썬 관련은 저 또한 개발자가 아니라 완벽한 답변을 될 수 없겠지만, 알아본 결과 오류의 대한 해결법은 gradio라는 모듈을 설치하는 겁니다. 커맨드창을 관리자 권한으로 열어서 cd C:\Users\pcroo\Desktop\Whisper-WebUI-master 라고 입력한 후 webui 설치된 폴더로 이동하고, pip install gradio라는 명령으로 gradio를 설치합니다.

이것으로 해결이 되지 않으면 https://github.com/jhj0517/Whisper-WebUI 여기가 위스퍼용 webui 제작자이니 질문을 하시는 게 좋을 겁니다.

안녕하세요 원문 따라하다가 막힌 부분이있어 문의 드립니다.

설치 다하고

http://127.0.0.1:7861/

http://127.0.0.1:7860/

위 두가지 주소에들어가는 단계에서

star-webui.bat 화면에

return t.to(device, dtype if t.is_floating_point() or t.is_complex() else None, non_blocking)

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 20.00 MiB (GPU 0; 8.00 GiB total capacity; 6.98 GiB already allocated; 0 bytes free; 7.32 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

라고 뜨는데 현재 램 16g고 보통 사용중 7g정도 나머지는 가용가능한데 위에 문장은 메모리 부족으로 인한 문제인거같은데 해결이 가능한가요?? 아니면 램을 더 늘리기 전까진 사용불가인가요??

그냥 램이 아니라 그래픽카드 v램을 늘리셔야 합니다. 혹은 large모델이 아니라 그 이하 모델을 설치하시고 진행해주시면 됩니다.

안녕하세요 램 부족으로 인해서 large모델말고 medium모델로 설치하고 싶은데 whisper설치폴더에는 large-v2.pt 파일 말고는 없는데 medium.pt파일은 어떻게 설치하는건가요??

http://nekaosoft.com/whisper/#vram-%EB%AC%B8%EC%A0%9C-%ED%95%B4%EA%B2%B0%EB%B2%95 해당 방법 참고하시면 기본 라지v2 모델에서 스몰이나 미디움으로 교환할 수 있습니다.

안녕하세요. 첫 mp3 파일은 large-v2로 변환이 되었는데 2번째 파일부터는 vram부족으로 튕기는데

원래 위스퍼 web-ui로 실행만하여도 vram을 10기가이상 잡아먹나요?

gpu는 rtx3060 12G입니다.

라지 모델 v2는 실제로 12기가정도 잡아먹는 거 같습니다. 아마 간당간당하게 걸려서 아웃오브메모리가 뜬 것 같습니다.

안녕하세요.

Git설치 , 파이썬 3.10.10(Add python 3.10 to PATH를 체크)설치

FFmpeg 설치후 패스추가,

install까지 완료하였으나,start-webui.bat 을 실행하면 아래메세지가 뜹니다.

무슨문제인가요?

venv “C:\Whisper-WebUI-master\\venv\Scripts\Python.exe”

Initializing Model..

Traceback (most recent call last):

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 1348, in do_open

h.request(req.get_method(), req.selector, req.data, headers,

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1282, in request

self._send_request(method, url, body, headers, encode_chunked)

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1328, in _send_request

self.endheaders(body, encode_chunked=encode_chunked)

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1277, in endheaders

self._send_output(message_body, encode_chunked=encode_chunked)

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1037, in _send_output

self.send(msg)

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 975, in send

self.connect()

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1454, in connect

self.sock = self._context.wrap_socket(self.sock,

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\ssl.py”, line 513, in wrap_socket

return self.sslsocket_class._create(

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\ssl.py”, line 1071, in _create

self.do_handshake()

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\ssl.py”, line 1342, in do_handshake

self._sslobj.do_handshake()

ConnectionResetError: [WinError 10054] 현재 연결은 원격 호스트에 의해 강제로 끊겼습니다

During handling of the above exception, another exception occurred:

Traceback (most recent call last):

File “C:\Whisper-WebUI-master\app.py”, line 24, in

whisper_inf = WhisperInference()

File “C:\Whisper-WebUI-master\modules\whisper_Inference.py”, line 15, in __init__

self.model = whisper.load_model(name=DEFAULT_MODEL_SIZE, download_root=”models/Whisper”)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\whisper\__init__.py”, line 108, in load_model

checkpoint_file = _download(_MODELS[name], download_root, in_memory)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\whisper\__init__.py”, line 50, in _download

with urllib.request.urlopen(url) as source, open(download_target, “wb”) as output:

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 216, in urlopen

return opener.open(url, data, timeout)

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 519, in open

response = self._open(req, data)

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 536, in _open

result = self._call_chain(self.handle_open, protocol, protocol +

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 496, in _call_chain

result = func(*args)

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 1391, in https_open

return self.do_open(http.client.HTTPSConnection, req,

File “C:\Users\mypc\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 1351, in do_open

raise URLError(err)

urllib.error.URLError:

계속하려면 아무 키나 누르십시오 . . .

해당 오류 메세지는 Python 프로그램이 모델 파일을 다운로드하려고 할 때 원격 서버에서 연결이 끊어졌음을 나타내는 것 같습니다. 이것은 일시적인 네트워크 문제일 수도 있고, 또는 원격 서버가 일시적으로 사용할 수 없거나 오류를 발생시킨 경우일 수도 있습니다.

안녕하세요

위에 댓글 분과 동일하게 그래픽카드 사양이 초과하여 large는 erorr가 발생합니다.

start-webui를 실행 시 large가 자동 설치 되는데 small로 변경해서 설치할 수 있는 방법이 있을까요?

아니면 small로 진행 하는 방법 질문 드립니다.

http://nekaosoft.com/whisper/#vram-%EB%AC%B8%EC%A0%9C-%ED%95%B4%EA%B2%B0%EB%B2%95 해당 방법 참고하시면 기본 라지v2 모델에서 스몰이나 미디움으로 교환할 수 있습니다.

안녕하세요.

사용법대로 설치를 했으나, VRAM이 8기가여서 모델을 미디움으로 설치를 해야할 것 같은데

어떻게 재설치를 해야하는지 몰라서 문의를 남깁니다. ㅠㅠ

알려주신대로 설치하면 large 버전이 자동을 설치되는것같습니다

medium 버전을 설치하려면 어떤방식으로 해야하는지 알려주실수있을까요?

좋은 정보 정말 감사합니다. 답변 기다리겠습니다!

return t.to(device, dtype if t.is_floating_point() or t.is_complex() else None, non_blocking)

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 20.00 MiB (GPU 0; 8.00 GiB total capacity; 7.00 GiB already allocated; 0 bytes free; 7.34 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

저도 위의 댓글과 같은 오류가 발생해서 그러는데 라지 모델이 아니라 다른모델을 선택해서 돌리는것은 어떻게하는건가요?

파이선 이나 다른거 설치 안하고도 사용 가능한가요?

파이썬을 설치하셔야 합니다.

안녕하세요! 글보고 설치하게 되었습니다. 우선 친절하고 상세한 설명 너무 감사합니다.

다만, 필요 프로그램을 전부 설치하고, start-webui.bat을 관리자 권한으로 실행할시

venv “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\\venv\Scripts\Python.exe”

C:\Users\wxwwx\AppData\Local\Programs\Python\Python310\python.exe: can’t open file ‘C:\\WINDOWS\\system32\\app.py’: [Errno 2] No such file or directory

이런 메세지가 출력되면서 실행이 되지 않습니다.

혹시 해결방법 여쭈어봐도 될런지요

파이썬 설치 시에 패스 지정을 하셔야합니다. 파이썬을 삭제하고 다시 설치해보세요. path 지정을 꼭 체크 하시고 하셔야합니다. 그리고 webui를 깔끔하게 삭제하시고, 다시 처음부터 설치하시면 될 겁니다.

안녕하세요 좋은 글 잘봤습니다. 안내해주신대로 설치하고 start-webui.bat 실행하였으나,

아래와 같은 오류가 출력되며 실행이 되지않습니다. 혹시 해결 방법이 있을까요?

Traceback (most recent call last):

File “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\app.py”, line 24, in

whisper_inf = WhisperInference()

File “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\modules\whisper_Inference.py”, line 15, in __init__

self.model = whisper.load_model(name=DEFAULT_MODEL_SIZE, download_root=”models/Whisper”)

File “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\venv\lib\site-packages\whisper\__init__.py”, line 122, in load_model

return model.to(device)

File “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 1145, in to

return self._apply(convert)

File “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 797, in _apply

module._apply(fn)

File “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 797, in _apply

module._apply(fn)

File “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 797, in _apply

module._apply(fn)

[Previous line repeated 2 more times]

File “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 820, in _apply

param_applied = fn(param)

File “C:\Users\wxwwx\Downloads\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 1143, in convert

return t.to(device, dtype if t.is_floating_point() or t.is_complex() else None, non_blocking)

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 20.00 MiB (GPU 0; 8.00 GiB total capacity; 6.96 GiB already allocated; 0 bytes free; 7.30 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

계속하려면 아무 키나 누르십시오 . . .

부디 조언 부탁드립니다.

안녕하세요

처음부터 설치를 했는데 오류가뜹니다ㅠㅠ

재설치해도 같은 오류가 발생합니다

venv “C:\Users\PC\Desktop\Whisper-WebUI-master\\venv\Scripts\Python.exe”

Initializing Model..

Traceback (most recent call last):

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 1348, in do_open

h.request(req.get_method(), req.selector, req.data, headers,

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1282, in request

self._send_request(method, url, body, headers, encode_chunked)

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1328, in _send_request

self.endheaders(body, encode_chunked=encode_chunked)

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1277, in endheaders

self._send_output(message_body, encode_chunked=encode_chunked)

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1037, in _send_output

self.send(msg)

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 975, in send

self.connect()

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\http\client.py”, line 1454, in connect

self.sock = self._context.wrap_socket(self.sock,

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\ssl.py”, line 513, in wrap_socket

return self.sslsocket_class._create(

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\ssl.py”, line 1071, in _create

self.do_handshake()

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\ssl.py”, line 1342, in do_handshake

self._sslobj.do_handshake()

ConnectionResetError: [WinError 10054] 현재 연결은 원격 호스트에 의해 강제로 끊겼습니다

During handling of the above exception, another exception occurred:

Traceback (most recent call last):

File “C:\Users\PC\Desktop\Whisper-WebUI-master\app.py”, line 24, in

whisper_inf = WhisperInference()

File “C:\Users\PC\Desktop\Whisper-WebUI-master\modules\whisper_Inference.py”, line 15, in __init__

self.model = whisper.load_model(name=DEFAULT_MODEL_SIZE, download_root=”models/Whisper”)

File “C:\Users\PC\Desktop\Whisper-WebUI-master\venv\lib\site-packages\whisper\__init__.py”, line 108, in load_model

checkpoint_file = _download(_MODELS[name], download_root, in_memory)

File “C:\Users\PC\Desktop\Whisper-WebUI-master\venv\lib\site-packages\whisper\__init__.py”, line 50, in _download

with urllib.request.urlopen(url) as source, open(download_target, “wb”) as output:

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 216, in urlopen

return opener.open(url, data, timeout)

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 519, in open

response = self._open(req, data)

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 536, in _open

result = self._call_chain(self.handle_open, protocol, protocol +

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 496, in _call_chain

result = func(*args)

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 1391, in https_open

return self.do_open(http.client.HTTPSConnection, req,

File “C:\Users\PC\AppData\Local\Programs\Python\Python310\lib\urllib\request.py”, line 1351, in do_open

raise URLError(err)

urllib.error.URLError:

계속하려면 아무 키나 누르십시오 . . .

무엇이 문제인지 알려주세요ㅠㅠㅠ

모델이 라지로 강제 설치되는데 다른 버젼으로 바꿀수는 없나요?

안녕하세요 설치하라는데로 다하고 start-webui 실행시

Traceback (most recent call last):

File “C:\Users\tkfah\Desktop\Whisper-WebUI-master\Whisper-WebUI-master\app.py”, line 24, in

whisper_inf = WhisperInference()

File “C:\Users\tkfah\Desktop\Whisper-WebUI-master\Whisper-WebUI-master\modules\whisper_Inference.py”, line 15, in __init__

self.model = whisper.load_model(name=DEFAULT_MODEL_SIZE, download_root=”models/Whisper”)

File “C:\Users\tkfah\Desktop\Whisper-WebUI-master\Whisper-WebUI-master\venv\lib\site-packages\whisper\__init__.py”, line 122, in load_model

return model.to(device)

File “C:\Users\tkfah\Desktop\Whisper-WebUI-master\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 1145, in to

return self._apply(convert)

File “C:\Users\tkfah\Desktop\Whisper-WebUI-master\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 797, in _apply

module._apply(fn)

File “C:\Users\tkfah\Desktop\Whisper-WebUI-master\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 797, in _apply

module._apply(fn)

File “C:\Users\tkfah\Desktop\Whisper-WebUI-master\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 797, in _apply

module._apply(fn)

[Previous line repeated 2 more times]

File “C:\Users\tkfah\Desktop\Whisper-WebUI-master\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 820, in _apply

param_applied = fn(param)

File “C:\Users\tkfah\Desktop\Whisper-WebUI-master\Whisper-WebUI-master\venv\lib\site-packages\torch\nn\modules\module.py”, line 1143, in convert

return t.to(device, dtype if t.is_floating_point() or t.is_complex() else None, non_blocking)

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 20.00 MiB (GPU 0; 8.00 GiB total capacity; 6.98 GiB already allocated; 0 bytes free; 7.32 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

이렇게 뜨는데 혹시 봐주실수있나요 ㅜㅜ 컴알못이라 ㅈ

브이램초과로 인한 오류입니다.

http://nekaosoft.com/whisper/#vram-%EB%AC%B8%EC%A0%9C-%ED%95%B4%EA%B2%B0%EB%B2%95

해당 방법 참고하시면 기본 라지v2 모델에서 스몰이나 미디움으로 교환할 수 있습니다.

안녕하세요? 아주 열심히 따라하고있는 중 start -webui 를 실행시키면

return t.to(device, dtype if t.is_floating_point() or t.is_complex() else None, non_blocking)

torch.cuda.OutOfMemoryError: CUDA out of memory. Tried to allocate 20.00 MiB (GPU 0; 8.00 GiB total capacity; 7.00 GiB already allocated; 0 bytes free; 7.34 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

이러한 오류가 뜹니다. 윗분하고 같은오류라서 어떻게 해결해야하나 찾아보다가 라지모델이 아닌 다른모델을 선택하라고 하셨는데 모델선택창이 아예 안떠서 어떻게 해야할지를 모르겠습니다 cmd만 켜져있는 상황이네요

브이램초과로 인한 오류입니다.

http://nekaosoft.com/whisper/#vram-%EB%AC%B8%EC%A0%9C-%ED%95%B4%EA%B2%B0%EB%B2%95

해당 방법 참고하시면 기본 라지v2 모델에서 스몰이나 미디움으로 교환할 수 있습니다.

필수 설치 파일 다운 안하고 https://huggingface.co/spaces/aadnk/faster-whisper-webui 여기 사이트만 사용해도 가능한가요?

네 근데 인터넷상으로 돌리는 거라 조금 느립니다. 허깅페이스 기반으로 한 webui도 설치할 수 있습니다. 글 마지막 링크를 참고해주세요. PDF 파일 다운받아서 똑같이 따라하면 됩니다.

자동번역을 필요 없고 싱크작업용으로 이런거 찾고 있었는데

mp3파일로 추출해서하면 vram 6~8g선에서 될거 같으니 보급형으로도 비벼볼만할거 같네요

좋은 정보 감사합니다

정말 좋은 정보 감사합니다

알려주신대로 해봤는데 Large 버전에 대한 설치방법 인것 같더라구요

Medium 버전에 대한 설치 방법도 알수있을까요?

브이램초과로 인한 오류입니다.

http://nekaosoft.com/whisper/#vram-%EB%AC%B8%EC%A0%9C-%ED%95%B4%EA%B2%B0%EB%B2%95

해당 방법 참고하시면 기본 라지v2 모델에서 스몰이나 미디움으로 교환할 수 있습니다.

올려주신 주소 2가지 전부 접속이 안 될 땐 어떻게 하나요?

설치는 잘 마친 것 같은데요

CMD 창에서 보통 설치가 제대로 완료되면

Running on local URL: http://127.0.0.1:7860

To create a public link, set `share=True` in `launch()`.

이런 메세지가 뜹니다. http://127.0.0.1:7860 이게 실행주소인데, 다른 webui를 설치했으면 주소가 다르게 나올 수도 있습니다. 주소에 Ctrl + 마우스 클릭하시면 주소로 접속될 겁니다.

설명 정말 감사합니다.

그런데 윗 댓글처럼 메모리부족 에러가 발생해서 모델을 낮은거로 바꾸고 싶은데 어떻게 해야하나요

제가 파이썬을 몰라서 방법을 잘 모르겠습니다 ㅎ

http://nekaosoft.com/whisper/#vram-%EB%AC%B8%EC%A0%9C-%ED%95%B4%EA%B2%B0%EB%B2%95

해당 방법 참고하시면 기본 라지v2 모델에서 스몰이나 미디움으로 교환할 수 있습니다.

설명 감사합니다.

알려주신 순서대로 설치가 완료되고 ‘start-webui’를 실행시키면

File “c:\whiper-webui-master\app.py” , line 1 , in import gradio as gr

ModuleNotFoundError: No module named ‘gradio’가 출력됩니다.

짧은 지식으로 구글링을 해서 gradio 는 pip install gradio 했더니 22.31 -> 23.12 로 되었다는것까진 확인했으나

이후 다시 시도해봐도 위와같이 동일한 메시지만 나오고 있습니다

어떻게 해결을 해야할까요?

환경은 윈도우10 pro 64입니다.

가상환경이 제대로 설치되지 않은 것으로 보입니다. 파이썬을 제대로 설치했는지 확인을 하셔야 할 것 같습니다. gradio는 Install.bat을 실행하면 자동으로 가상환경을 구성하고, 그 가상환경에 gradio를 설치합니다. 파이선 설치 시에 패스 등록을 정확하게 했는지 확인해보세요. git이 설치되지 않았을 경우도 있습니다. 다시 한번 처음부터 해보시길 바랍니다.

6700xt 라데온을 사용하고 있는데 자막 적용하는데 cpu만 사용하네요 GPU를 쓰게 하는 방법이 없을까요?

이게 위스퍼나 오픈ai 같은 경우에는 엔비디아 cudnn을 사용하여 추론 및 연산 작업을 합니다. 그게 아니라면 cpu로 하고 있습니다. ai 작업시에는 대부분 엔비디아 그래픽카드를 이용하는 이유입니다.

정말 감사합니다.

공유해주신 파일로 size 변경하여 이상없이 진행중입니다.

선생님 다른 size로 변경 된 파일 공유 감사드립니다.

GPU 문제는 해결 하였지만, 파일을 SRT로 변역시 Error가 발생합니다

File “C:\Users\USER\AppData\Local\Programs\Python\Python310\lib\subprocess.py”, line 1440, in _execute_child

hp, ht, pid, tid = _winapi.CreateProcess(executable, args,

FileNotFoundError: [WinError 2] 지정된 파일을 찾을 수 없습니다

하기의 문제가 발생 하는데 어떤 문제일까요?

파이선 설치할 때, 패스 체크를 해야 합니다. 파이선을 다시 한 번 깔아보시길 바랍니다.

안녕하세요. 다름이 아니오라 모든 설치를 완료하고 cuda, cudnn 까지 설치를 다 했습니다.

그런데 web ui 인터페이스에서 파일을 업로드 하고 번역하려고 하면 에러가 뜹니다.

왜 이러는 걸까요? 코랩에서도 사용해봤는데 large 버전 번역하는데에 너무 오래걸려서

3090 24g 로 변경을 했는데도 불구하고 코랩에서는 여전히 엄청 느립니다. 이건 gpu를 사용을 못하는 거라고 봐도 되나요?

코랩은 구글에 컴퓨터로 작업을 진행하는 것이기에 매우 한정된 그래픽 자원만 사용합니다. 로컬로 돌려야 빠릅니다. 만약 로컬에서 돌리는 게 오류가 난다면, 재설치를 권장해드립니다. 사실 컴퓨터 적인 문제는 여러 문제가 있을 수도 있어서 3090으로 large 버전이 돌아가지 않는다면, 다른 문제가 있을 수도 있습니다.

안녕하세요. 지금 제가 쓰는 3090 24g 로 large 버전을 소화하지 못하는데 어떻게 하면 될까요?

아예 gpu 사용을 안 하는 것 같습니다..

음, 애초에 원클릭 설치시에 cudnn이랑 다 동시에 깔립니다. 그래픽카드 드라이버 등을 재설치 해보시고, 그게 안 되면 마지막에 허깅 페이스 버전을 사용해보시길 바랍니다.

안녕하세요.

궁굼한 점이 있는데요.

자막 추출전 파일을 업로드 하는데, 이파일이 다른사람들에게 공유 되거나 하는 문제는 없을까요?

네 그냥 자기 컴퓨터에서 돌리는 거고, 웹으로 실행하는 건 인터페이스를 활용하기 위해 그런 겁니다. 다른 서버로 업로드 되는 게 아니라 사용자의 c드라이브 특정 경로에 업로드 되고, 거기서 작업이 진행됩니다.

안녕하세요 덕분에 잘 사용하고 있습니다.

계속 사용하니까 어디서 용량을 잡아먹는 거 같은데 어디인지 찾을 수가 없습니다.

어디서 용량을 잡아먹는 건지 혹시 아시나요??

C:\Users\[유저이름]\AppData\Local\Temp -> 여기에 저장됩니다. 이름이 바뀌기에 크기명으로 정렬하셔야 합니다.

좋은 정보 감사합니다.

모두 설치 후 자막 생성중인데 2시간 짜리 mp4파일을 mp3 62메가 파일로 변환 후

large-v2, srt 선택하고 generate subtitle file 를 눌렀는데 Initializing Model.. – 0.0%

에서 시간만 지금기준 18000계속 올라가고 변화가 없습니다. 다시 해봐도 그런데

계속 기다려봐야 하나요 원래 이렇게 오래 걸리는건지 뭔가 잘못된건지 궁금합니다.

너무 길어서 그런 것 같은데, 나눠서 해보시거나 다른 모델을 이용해보시길 바랍니다.

안녕하세요 설치 후 start-webui를 실행하면 아래와 같이 뜹니다.

해결 방법을 아시나요?

venv “C:\Whisper-WebUI-master\\venv\Scripts\Python.exe”

Traceback (most recent call last):

File “C:\Whisper-WebUI-master\app.py”, line 1, in

import gradio as gr

File “C:\Whisper-WebUI-master\venv\lib\site-packages\gradio\__init__.py”, line 3, in

import gradio.components as components

File “C:\Whisper-WebUI-master\venv\lib\site-packages\gradio\components.py”, line 34, in

from gradio import media_data, processing_utils, utils

File “C:\Whisper-WebUI-master\venv\lib\site-packages\gradio\processing_utils.py”, line 25, in

from gradio import encryptor, utils

File “C:\Whisper-WebUI-master\venv\lib\site-packages\gradio\encryptor.py”, line 2, in

from Crypto.Cipher import AES

File “C:\Whisper-WebUI-master\venv\lib\site-packages\Crypto\Cipher\__init__.py”, line 30, in

from Crypto.Cipher._mode_ofb import _create_ofb_cipher

File “C:\Whisper-WebUI-master\venv\lib\site-packages\Crypto\Cipher\_mode_ofb.py”, line 37, in

raw_ofb_lib = load_pycryptodome_raw_lib(“Crypto.Cipher._raw_ofb”, “””

File “C:\Whisper-WebUI-master\venv\lib\site-packages\Crypto\Util\_raw_api.py”, line 309, in load_pycryptodome_raw_lib

raise OSError(“Cannot load native module ‘%s’: %s” % (name, “, “.join(attempts)))

OSError: Cannot load native module ‘Crypto.Cipher._raw_ofb’: Not found ‘_raw_ofb.cp310-win_amd64.pyd’, Not found ‘_raw_ofb.pyd’

계속하려면 아무 키나 누르십시오 . . .

안녕하세요

궁금한 점이 있습니다

삭제 하고 싶을 때는 어떤 폴더를 지우면 될까요?

venv 폴더랑 그냥 폴더 전체를 삭제해주시면 됩니다.

안녕하세요

혹시 업로드 된 파일 용량 차지하는 부분이

자동적으로 삭제가 안되던데

경로 어디 들어가서 지우면 되나요?

본문에 Temp 파일 지우라고 되있던데

whisper ui 파일을 지워도 업로드한 파일 용량이 지워지지 않습니다

temp파일은 어디에 위치해 있나요?

C:\Users\[유저이름]\AppData\Local\Temp -> 여기에 저장됩니다. 이름이 바뀌기에 크기명으로 정렬하셔야 합니다.

어우; 어려워;;;

무설치본이랑 설치본이랑 v2로 같은 mp3 파일을 자막 생성해봤는데 무설치본이 더 정확하고 설치본이 오류가 많습니다 왜 이런걸까요?

무설치본이 허깅페이스 말씀하시는 거라면, 허깅페이스도 로컬로 돌릴 수 있습니다. 제 글 마지막에 허깅페이스 버전을 다운로드 받은 PDF 공유 했으니 그걸 이용하셔도 괜찮을 거 같습니다. 저도 최근에 이걸 이용중입니다.

3070을 쓰고있고 모델라지v2로 진행하면 cmd창에서 100퍼 될때쯤에

model has been downloaded but the sha256 checksum does not not match.라는 메세지가 뜨면서 에러를 뿜네요. 어떻게 해야하나요

미디움 파일도 받아봤는데 다른 모델은 실행조차 안되고 에러가 떠요

모델이 정확하지 않게 다운로드 된 것 같습니다. 재설치해보시거나 허깅페이스 이용하시는 게 좋을 거 같습니다.

선생님 완벽하게 따라했는데

사이트에 파일끌어놓고 업로딩 뜨면 cmd창에

To create a public link, set `share=True` in `launch()`.

ERROR: Exception in ASGI application

Traceback (most recent call last):

File “C:\Whisper-WebUI-master\venv\lib\site-packages\uvicorn\protocols\http\h11_impl.py”, line 428, in run_asgi

result = await app( # type: ignore[func-returns-value]

File “C:\Whisper-WebUI-master\venv\lib\site-packages\uvicorn\middleware\proxy_headers.py”, line 78, in __call__

return await self.app(scope, receive, send)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\fastapi\applications.py”, line 276, in __call__

await super().__call__(scope, receive, send)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\applications.py”, line 122, in __call__

await self.middleware_stack(scope, receive, send)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\middleware\errors.py”, line 184, in __call__

raise exc

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\middleware\errors.py”, line 162, in __call__

await self.app(scope, receive, _send)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\middleware\cors.py”, line 91, in __call__

await self.simple_response(scope, receive, send, request_headers=headers)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\middleware\cors.py”, line 146, in simple_response

await self.app(scope, receive, send)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\middleware\exceptions.py”, line 79, in __call__

raise exc

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\middleware\exceptions.py”, line 68, in __call__

await self.app(scope, receive, sender)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\fastapi\middleware\asyncexitstack.py”, line 21, in __call__

raise e

File “C:\Whisper-WebUI-master\venv\lib\site-packages\fastapi\middleware\asyncexitstack.py”, line 18, in __call__

await self.app(scope, receive, send)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\routing.py”, line 718, in __call__

await route.handle(scope, receive, send)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\routing.py”, line 276, in handle

await self.app(scope, receive, send)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\starlette\routing.py”, line 66, in app

response = await func(request)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\fastapi\routing.py”, line 237, in app

raw_response = await run_endpoint_function(

File “C:\Whisper-WebUI-master\venv\lib\site-packages\fastapi\routing.py”, line 163, in run_endpoint_function

return await dependant.call(**values)

File “C:\Whisper-WebUI-master\venv\lib\site-packages\gradio\routes.py”, line 530, in upload_file

await file_manager.save_uploaded_file(

File “C:\Whisper-WebUI-master\venv\lib\site-packages\gradio\processing_utils.py”, line 410, in save_uploaded_file

output_file_obj = tempfile.NamedTemporaryFile(

File “C:\Users\USER1\AppData\Local\Programs\Python\Python310\lib\tempfile.py”, line 559, in NamedTemporaryFile

file = _io.open(dir, mode, buffering=buffering,

File “C:\Users\USER1\AppData\Local\Programs\Python\Python310\lib\tempfile.py”, line 556, in opener

fd, name = _mkstemp_inner(dir, prefix, suffix, flags, output_type)

File “C:\Users\USER1\AppData\Local\Programs\Python\Python310\lib\tempfile.py”, line 256, in _mkstemp_inner

fd = _os.open(file, flags, 0o600)

FileNotFoundError: [Errno 2] No such file or directory:

요런식인데 어디가 문제일가요 ㅠ

디덱토리가 정확하지 않은 것 같습니다. 지정된 디렉토리가 존재하는지 확인합니다. 임시 파일이 생성되는 경로를 확인하고 해당 디렉토리가 있는지 확인합니다.

디렉토리의 권한을 확인합니다. 어플리케이션이 디렉토리 내에 파일을 생성할 수 있도록 읽기 및 쓰기 권한이 있는지 확인합니다.

디렉토리가 존재하지 않는 경우 수동으로 생성하거나 임시 파일을 생성하기 전에 코드를 업데이트하여 디렉토리를 생성합니다.

코드에서 파일 경로와 이름을 확인하여 실제 파일의 위치와 이름과 일치하는지 확인합니다.

파이선을 아무리 삭제 후 PATH누르고 재설치해도 install을 하려하면

Creating venv…

checked the venv folder. now installing requirements..

지정된 경로를 찾을 수 없습니다.

‘activate.bat’은(는) 내부 또는 외부 명령, 실행할 수 있는 프로그램, 또는

배치 파일이 아닙니다.

라고 뜹니다 20번정도 했는데 정신 나가겠네요

처음 설치때는 됐었는데 그래픽카드 바뀐 뒤 GPU가 아닌 CPU만 사용해서 재설치하니 안깔리는데 원인이 뭘까요?

Whisper-WebUI-master 폴더의 venv 폴더를 완전히 다시 삭제하시고 설치해보셨나요? 폴더 자체를 완전히 비우시고 다시 해보시길 바랍니다. 위스퍼를 실행하기 위한 가상 환경이 Whisper-WebUI-master/venv에 만들어집니다. 만약 이것도 안 된다면, 위스퍼 허깅페이스 버전을 설치해보시기 바랍니다.

문제해결했습니다.

파이썬 설치 시 커스텀 옵션으로 들어가서 모든 유저에 체크하고 설치하니 되네요

왜 문제였는지는 모르지만 잘 해겼되었습니다.

답변 감사드립니다.

혹시 설치중에 지정된 경로를 찾을 수 없습니다 에러 뜨면

Whisper-WebUI-master 폴더를 C드라이브에 놓고 설치해보시기 바랍니다.

경로에 뭐가 껴있으면 venv 폴더 설치를 못하는 경우가 있는 것 같아요.

저는 C드라이브에 놓고 재설치해서 해결봤습니다.

Error: [WinError 2] 지정된 파일을 찾을 수 없습니다

설치 하고 파일 올려서 돌리려는데 이렇게 뜨는데 방법있나요

medium으로 코드 수정했습니다. ffmpeg도 알려주신대로 깔았는데 여기서 막히네요

리플 수정이 안되서 줄줄이 쓰는점 양해부탁드립니다.

C:\Whisper-WebUI-master\venv\lib\site-packages\torch\cuda\memory.py:303: FutureWarning: torch.cuda.reset_max_memory_allocated now calls torch.cuda.reset_peak_memory_stats, which resets /all/ peak memory stats. warnings.warn(

이런 에러가 뜹니다.

To create a public link, set `share=True` in `launch()`.

C:\Whisper-WebUI-master\venv\lib\site-packages\torch\cuda\memory.py:303: FutureWarning: torch.cuda.reset_max_memory_allocated now calls torch.cuda.reset_peak_memory_stats, which resets /all/ peak memory stats.

warnings.warn(

Traceback (most recent call last):

File “C:\Whisper-WebUI-master\venv\lib\site-packages\gradio\routes.py”, line 384, in run_predict

output = await app.get_blocks().process_api(

File “C:\Whisper-WebUI-master\venv\lib\site-packages\gradio\blocks.py”, line 1024, in process_api

result = await self.call_function(

File “C:\Whisper-WebUI-master\venv\lib\site-packages\gradio\blocks.py”, line 836, in call_function

prediction = await anyio.to_thread.run_sync(

File “C:\Whisper-WebUI-master\venv\lib\site-packages\anyio\to_thread.py”, line 33, in run_sync

return await get_asynclib().run_sync_in_worker_thread(

File “C:\Whisper-WebUI-master\venv\lib\site-packages\anyio\_backends\_asyncio.py”, line 877, in run_sync_in_worker_thread

return await future

File “C:\Whisper-WebUI-master\venv\lib\site-packages\anyio\_backends\_asyncio.py”, line 807, in run

result = context.run(func, *args)

File “C:\Whisper-WebUI-master\modules\whisper_Inference.py”, line 79, in transcribe_file

self.remove_input_files([fileobj.name for fileobj in fileobjs])

File “C:\Whisper-WebUI-master\modules\base_interface.py”, line 21, in remove_input_files

os.remove(file_path)

PermissionError: [WinError 32] 다른 프로세스가 파일을 사용 중이기 때문에 프로세스가 액세스 할 수 없습니다.

지속적인 오류입니다. 무엇이 문제일까요??

한 5번넘게 재설치 하고 기오코 성공했네요 이런글 써주셔서 감사합니다~

파이썬 path 체크해주고 repair 눌러주고

관리자 권한으로 실행안하고 그냥 클릭했고

첫번째링크는 안되고 두번째 링크는 접속 가능하네요

너무 신납니다~ 선생님 좋은하루 보내세여.

안녕하세요 혹시 몰라 질문드립니다.

파이썬 3.10.11

torch 2.0.1+cu118

whisper 3월 14일 릴리즈

cuda 12.1

cudnn 8.7.0

4070 12gb

이렇게 설치해서 사용중인데 처리 속도가 올라갔다가 내려갔다가 합니다. 3000프레임 나오다가 120프레임 나오고 이런 식으로 차이가 너무 큽니다.

다른 오류들이아 위스퍼 오류라 그렇다고 치는데 속도가 너무 일정하게 안나와서 혹시 속도 관련해서 알고계신게 있으시면 아무거나 상관없으니 알려주셨으면 합니다 올리신 다른 글(4090)도 참고했습니다.

좋은 강좌 감사합니다. 위스퍼ai 글은 별로 없어서 덕분에 잘 따라했습니다.

그런데 몇 가지 질문드리고 싶은 게 있는데요, 제가 알기로 구글 코랩은 3060 정도의 퍼포먼스라고 알고 있는데, 제 시스템은 4070인데 둘 다 속도가 동일하게 나오더라고요.(2시간 30분짜리 영상을 돌렸을 때 둘 다 41분 정도 소요) 4070이면 구글 코랩보다 훨씬 빠를 거라고 생각했는데 이게 정상인가요? 아니면 ai는 비램에만 영향을 받나요?

그리고 왜인지 결과물의 퀄리티에도 차이가 있어서 이것도 문제인데, 여러번 돌려봐도 구글 코랩 쪽이 자막 싱크나 정확도 면에서 훨씬 좋은 품질이 나옵니다. 둘 다 large-v2 모델을 쓰고 있고 동일한 설정으로 자막생성을 하는데 왜 이런 차이가 생기는 걸까요?

안녕하세요

속도가 안나와서 확인해보니 CPU로 돌리고 있는 것을 확인해서

실행했을때 아래처럼 cpu를 잡고 실행이 되는 것 같습니다.

그래픽카드도 엔비디아고 gpu로 바꿀 수 있는 방법이 있을까요?

Use Faster Whisper implementation

Device “cpu” is detected

안녕하세요

위스퍼 ai 잘하고 있는데요 다른 버전이 또 나왔더라고요 ..

stable-ts ai 번역 이거요 위스퍼 ai보다 더 잘된다고 하더라고요

위스퍼 ai는 후반 갈수록 점점 번역이 안나오잖아요 그런게없어서

stable-ts ai 이건 WebUI로 하는 강좌가 없어서 못따라 하겠어요

woohyen Jang 관리자님 엄청 잘하잖아요

나중에 시간 엄청 남으면 한번 강좌 해주세요 감사합니다 새해 복많이 받으세요 2025년